谷歌爆改transformer,“无尽注意力”让1b小模子读完10部小说,114倍音讯压缩

谷歌大改Transformer,“无限”长度上下文来了。

现在,1B大模型上下文长度可扩展到1M(100万token,大约相当于10部小说),并能完成Passkey检索任务。

8B大模型在500K上下文长度的书籍摘要任务中,拿下最新SOTA。

这就是谷歌最新提出的Infini-attention机制(无限注意力)。

它能让Transformer架构大模型在有限的计算资源里处理无限长的输入,在内存大小上达成114倍压缩比。

什么概念?

就是在内存大小不变的情况下,放进去114倍多的信息。好比一个存放100本书的图书馆,通过新技术能存储11400本书了。

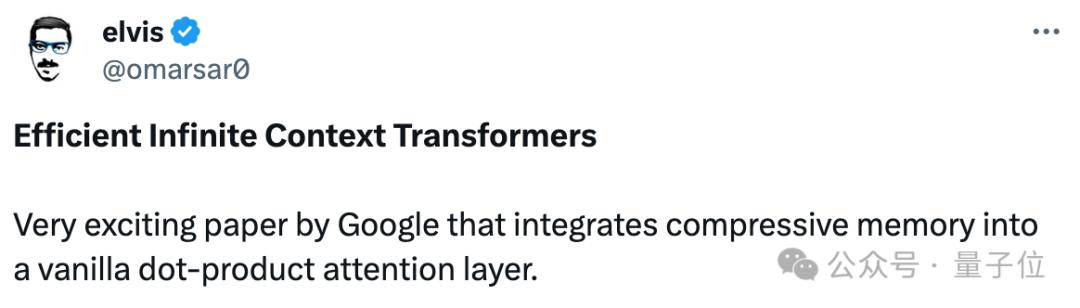

这项最新成果立马引发学术圈关注,大佬纷纷围观。

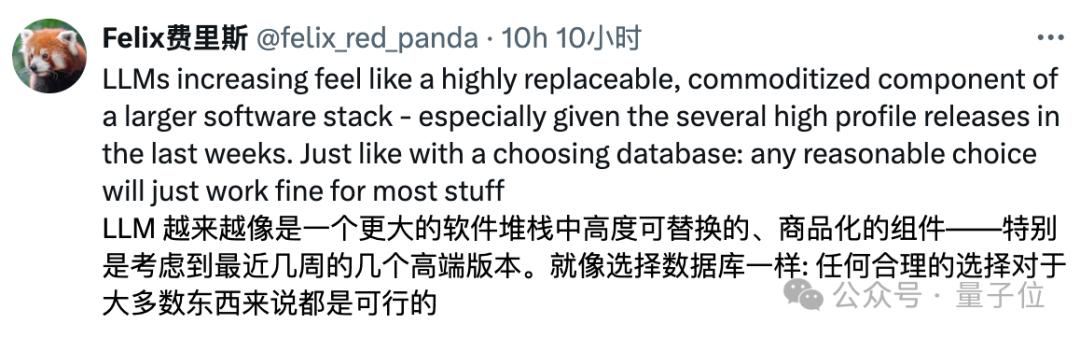

加之最近DeepMind也改进了Transformer架构,使其可以动态分配计算资源,以此提高训练效率。

有人感慨,基于最近几个新进展,感觉大模型越来越像一个包含高度可替换、商品化组件的软件栈了。

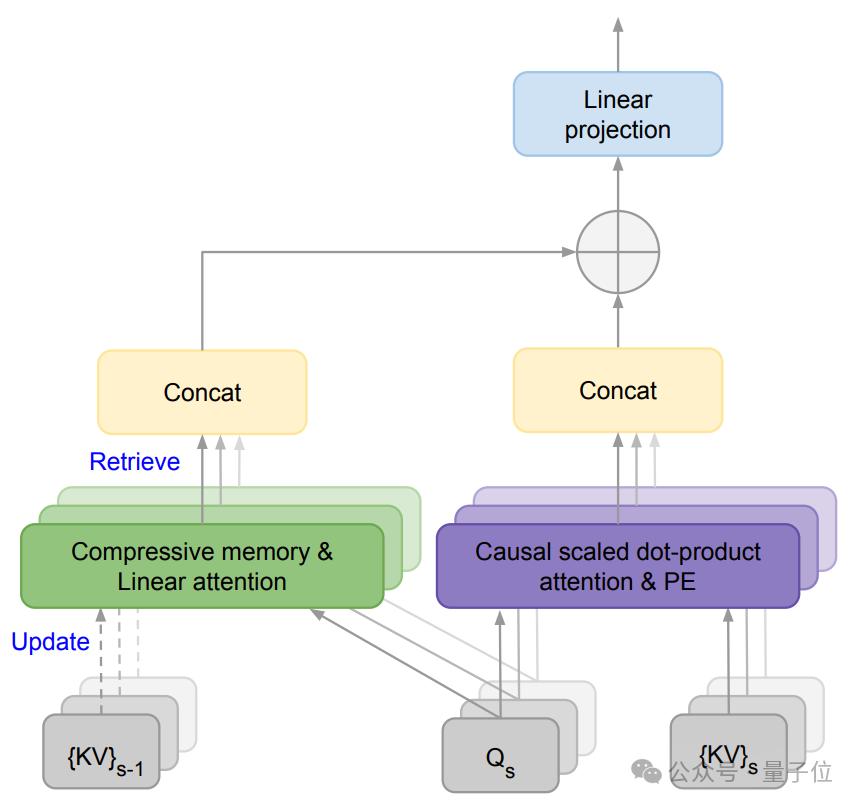

该论文核心提出了一种新机制Infini-attention。

它通过将压缩记忆(compressive memory)整合到线性注意力机制中,用来处理无限长上下文。

压缩记忆允许模型在处理新输入时保留和重用之前的上下文信息。它通过固定数量的参数来存储和回忆信息,而不是随着输入序列长度的增加而增加参数量,能减少内存占用和计算成本。

线性注意力机制不同于传统Transformer中的二次方复杂度注意力机制,它能通过更小的计算开销来检索和更新长期记忆。

在Infini-attention中,旧的KV状态({KV}s-1)被存储在压缩记忆中,而不是被丢弃。

通过将查询与压缩记忆中存储的键值进行(Carry Out)匹配,模型就可以检索到相关的值。

PE表示位置嵌入,用于给模型提供序列中元素的位置信息。

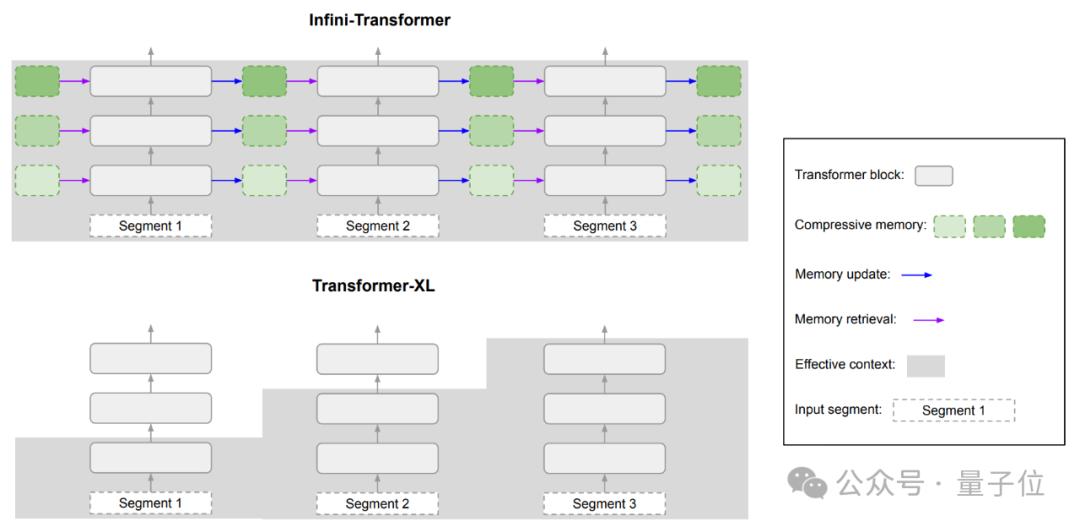

对比来看Transformer-XL,它只缓存最后一段KV状态,在处理新的序列段时就会丢弃旧的键值对,所以它只能保留最近一段的上下文信息。

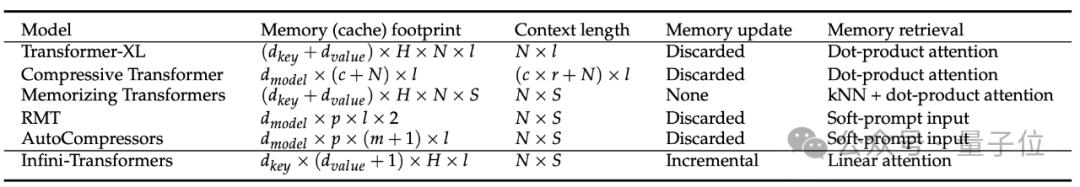

对比几种不同Transformer模型可处理上下文的长度和内存占用情况。

Infini-attention能在内存占用低的情况下,有效处理非常长的序列。

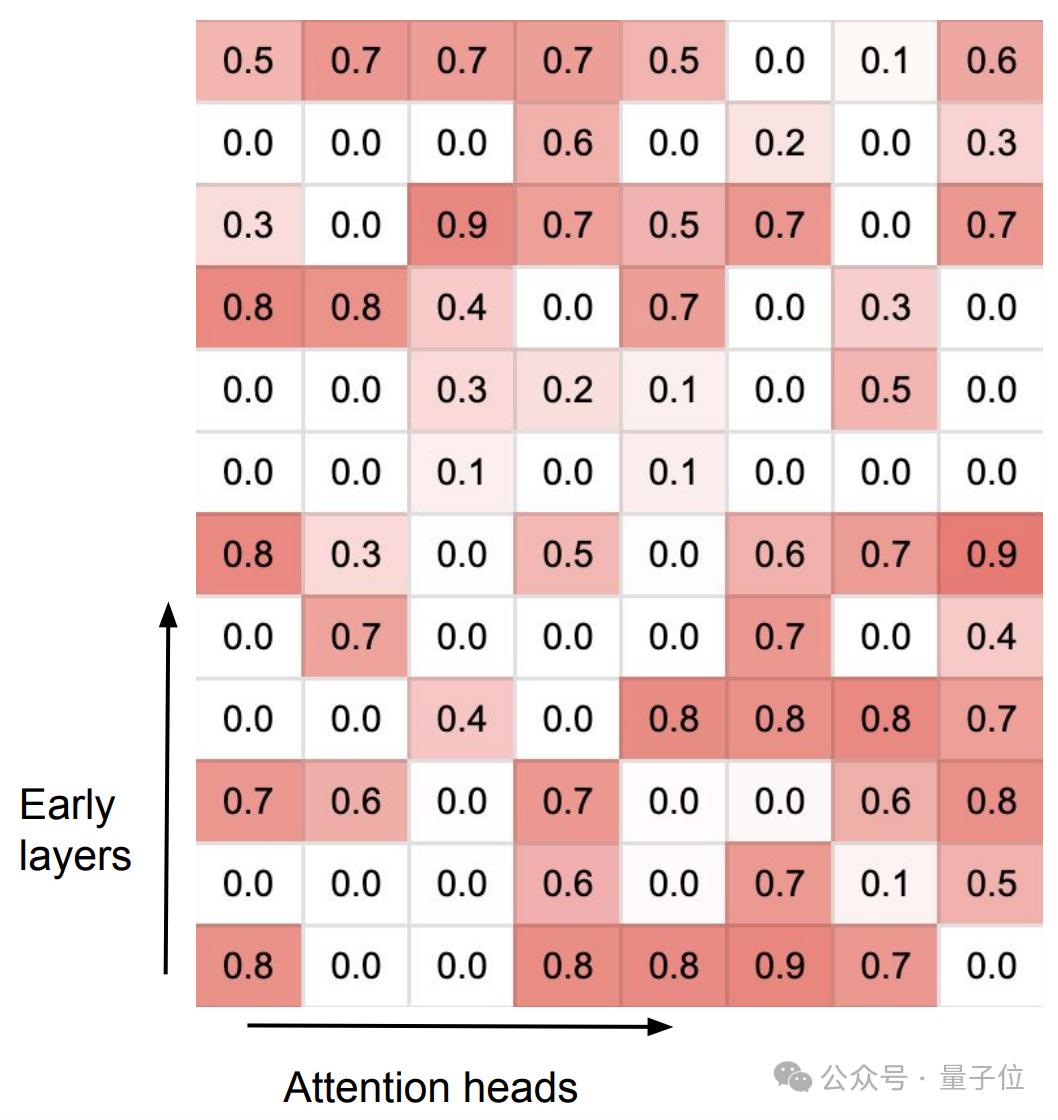

Infini-attention在训练后,分化出了两种不同类型的注意力头,它们(They)协同处理长期和短期上下文信息。

专门化的头(Specialized heads):这些头在训练过程中学习到了特定的功能,它们(They)的门控得分(gating score)接近0可能1。这意味着它们(They)要么通过局部注意力机制处理当前的上下文信息,要么从压缩记忆中检索信息。

混合头(Mixer heads):这些头的门控得分接近0.5,它们(They)的作用是将当前的上下文信息和长期记忆内容聚合到单一的输出中。

研究团队将训练长度增加到100K,在Arxiv-math数据集上进行(Carry Out)训练。

在长下文语言建模任务中,Infini-attention在保持低内存占用的同时,困惑度更低。

对比来看,同样情况下Memorizing Transformer存储参数所需的内存是Infini-attention的114倍。

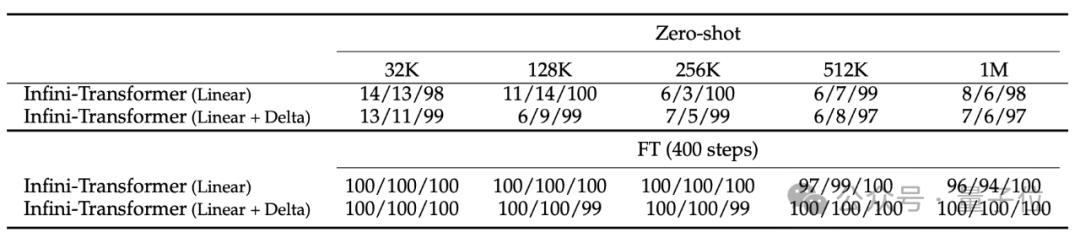

消融实验比较了“线性”和“线性+增量”记忆两种模式,结果(Result)显示性能相当。

实验结果(Result)显示,即使在输入只有5K进行(Carry Out)微调的情况下,Infini-Transformer可成功(Success)搞定1M长度(100万)的passkey检索任务。

在处理长达500K长度的书籍摘要任务时,Infini-Transformer达到最新SOTA。

该研究由谷歌团队带来。

其中一位作者(Manaal Faruqui)在Bard团队,领导研究Bard的模型质量、指令遵循等问题。

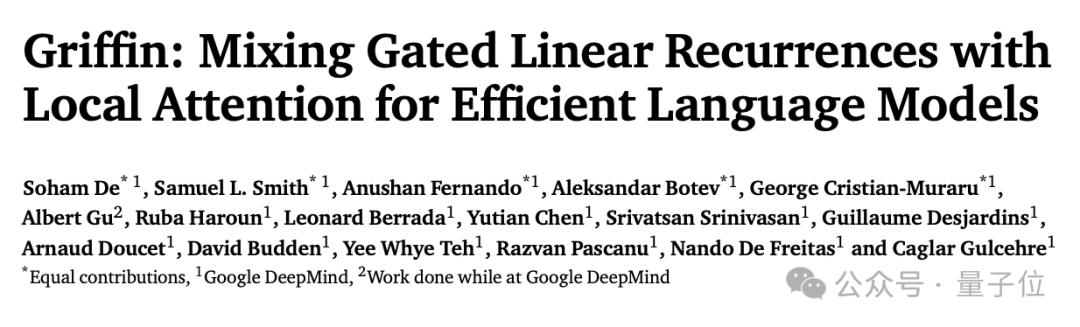

最近,DeepMind的一项工作也关注到了高效处理长序列数据上。他们(They)提出了两个新的RNN模型,在高效处理长序列时还达成了和Transformer模型相当的性能和效率。

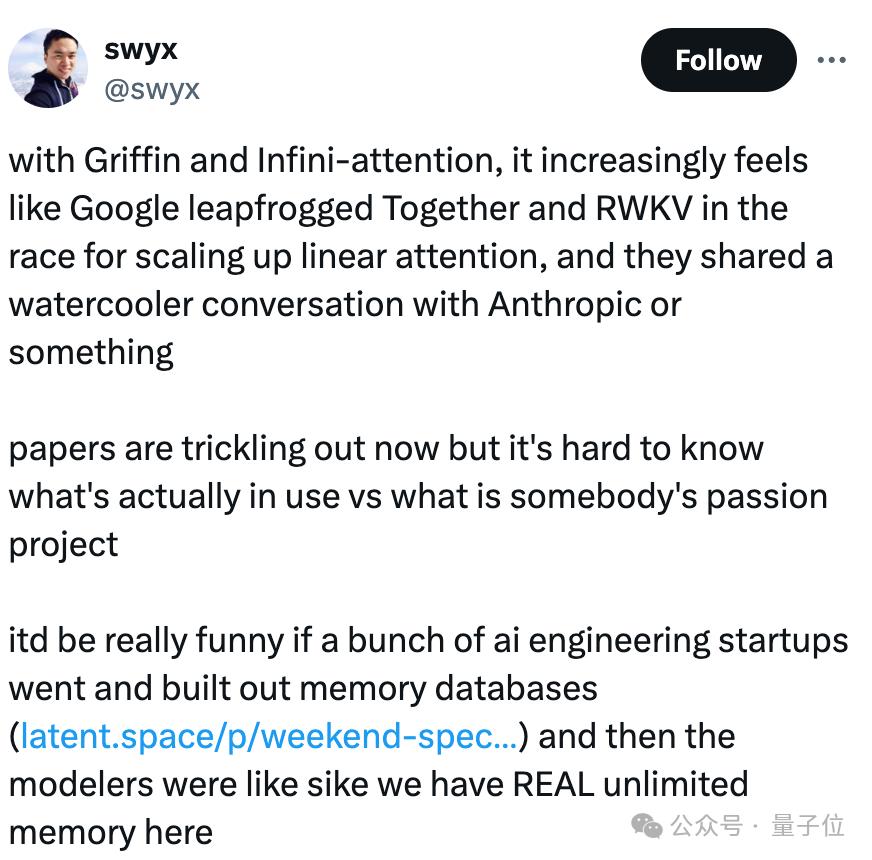

感觉到谷歌最近的研究重点之一就是长文本,论文在陆续公布。

网友觉得,很难了解哪些是真正开始推行使用的,哪些只是一些研究员心血来潮的成果。

不过想象一下,如果有一些初创公司专门做内存数据库,但是模型能已经能达成无限内存了,这可真是太有趣了。

论文地址:https://arxiv.org/abs/2404.07143

参考链接:[1]https://twitter.com/Joby_Fi/status/1778240236201386072[2]https://twitter.com/omarsar0/status/1778480897198612839[3]https://twitter.com/swyx/status/1778553757762252863

本文来自微信公众号“量子位”(ID:QbitAI),作者:明敏,36氪经授权发布。

该文观点仅代表作者本人,36氪平台仅提供信息存储空间服务。

+17好文章,需要你的鼓励

量子位特邀作者2收 藏+10评 论打开微信“扫一扫”,打开网页后点击屏幕右上角分享按钮微 博沉浸阅读返回顶部参与评论评论千万条,友善第一条登录后参与讨论(Discuss)提交评论0/1000你可能也喜欢这些文章首批 Ai Pin 用户集体劝退,「AI 时代的 iPhone」把人变得愚蠢突发:OpenAI开除Ilya盟友,理由:涉嫌信息泄漏GPT-4升级被曝引入Q*,推理/数学更强废话更少,竞技场重夺王位这款AI文献神器,能让“论文党”少掉些头发|New Things用AI帮企业跑通财税服务全流程,「创业爸爸」获1000万元融资|36氪首发谷歌大脑DeepMind「婚后」貌合神离,Hassabis怨气冲天,1+1 1OpenAI内斗第二弹,Ilya亲信、超级对齐团队2人惨遭开除,被批泄密GPT-4 Turbo重回王座,ChatGPT免费升级,数学暴涨10%/上下文全面碾压AI Agent,垂直AI重塑B2B价值链的关键最新文章推荐36氪首发丨「咖爷科技(Technology)」完成数千万元A轮融资,自研商用全自动咖啡机「Smart X」首批 Ai Pin 用户集体劝退,「AI 时代的 iPhone」把人变得愚蠢开放式耳机市场再迎力作 Shokz韶音春季新品重磅发布突发:OpenAI开除Ilya盟友,理由:涉嫌信息泄漏硅谷 CEO 立「千万赌约」,邀马斯克应战:“我用 1000 万美元,赌你的 AI 预测是错的!”银行现黄金回购潮,有网点已排队到下周,17家银行回购条款各不相同谷歌爆改Transformer,“无限注意力”让1B小模型读完10部小说,114倍信息压缩GPT-4升级被曝引入Q*,推理/数学更强废话更少,竞技场重夺王位这届年轻人,组团按摩这款AI文献神器,能让“论文党”少掉些头发|New Things 量子位特邀作者

量子位特邀作者作者有点忙,还没写简介

发表文章2138篇最近内容突发:OpenAI开除Ilya盟友,理由:涉嫌信息泄漏49分钟前谷歌爆改Transformer,“无限注意力”让1B小模型读完10部小说,114倍信息压缩50分钟前GPT-4升级被曝引入Q*,推理/数学更强废话更少,竞技场重夺王位50分钟前阅读更多内容,狠戳这里下一篇GPT-4升级被曝引入Q*,推理/数学更强废话更少,竞技场重夺王位新版GPT-4重回竞技场榜一

50分钟前

热门标签智能投顾理财平台金百万烤鸭邓超全聚德互联网产业联想电脑(Computer)喜剧片博纳影业漫画国庆节松鼠新天津树袋熊供应链彭博数据新闻(News)交易员玛莎百货第二杯bitfinex数字货币货币ios11矿机瑞波币日本(Japan)货币xrp软件关于36氪城市合作寻求报道我要入驻投资者关系商务合作关于我们(We)联系我们(We)加入我们(We)网站谣言信息举报入口热门推荐热门资讯热门产品文章标签快讯标签合作伙伴

iOS Android

iOS Android 本站由 阿里云 提供计算与安危服务 违法和不良信息、未成年人保护举报电话:010-89650707 举报邮箱:jubao@36kr.com 网上有害信息举报© 2011~2024 首都多氪信息科技(Technology)有限公司 | 京ICP备12031756号-6 | 京ICP证150143号 | 京公网安备11010502036099号意见反馈

本站由 阿里云 提供计算与安危服务 违法和不良信息、未成年人保护举报电话:010-89650707 举报邮箱:jubao@36kr.com 网上有害信息举报© 2011~2024 首都多氪信息科技(Technology)有限公司 | 京ICP备12031756号-6 | 京ICP证150143号 | 京公网安备11010502036099号意见反馈 36氪APP让一部分人先看到将来36氪鲸准氪空间

36氪APP让一部分人先看到将来36氪鲸准氪空间

推送和解读前沿、有料的科技(Technology)创投资讯

一级市场金融信息和系统服务提供商

聚焦全球优秀创业者,项目融资率接近97%,领跑行业

- 赞(605) 踩(46) 阅读数(2890) 最新评论 查看所有评论

-

加载中......

- 发表评论

-